AI 助成金から始めて、ナット フリードマンとダニエル グロスが米国の人工知能の半分にどのように投票したかをご覧ください

2023-08-28 06:36

AI 自律エージェントの目録、構築、適用、評価の完全な内容、全人代高陵の Wen Jiron 氏による 32 ページの概要

2023-08-28 06:23

人気の話題

もっと見る1.67K 人気度

14.41K 人気度

10.53K 人気度

5.43K 人気度

92.31K 人気度

人気の Gate Fun

もっと見る- 時価総額:$3.86K保有者数:21.12%

- 時価総額:$3.61K保有者数:20.00%

- 時価総額:$3.64K保有者数:10.00%

- 時価総額:$3.63K保有者数:10.00%

- 時価総額:$3.94K保有者数:21.44%

ピン

Microsoftの深夜増幅の動き:GPT-4、DALL· E 3. GPTは無料で使用でき、大規模モデル用の自社開発AIチップ

出典: Heart of the Machine

今朝の早い時間に、Microsoftは最新のIgniteカンファレンスを開催し、CEOのSatya Nadellaが、幅広いアプリケーション、生産性、およびセキュリティをカバーする100を超える製品とテクノロジーのリリースとアップデートを紹介しました。

このカンファレンスでは、Nvidiaの創業者であるJensen Huang氏も招待され、MicrosoftはAMDとNvidiaの最新プロセッサをAzureクラウドサービスに組み込む予定です。

Bing チャットが「副操縦士」に名称変更、GPT-4、DALL・E 3、GPT は無料で使用できます

カンファレンスで、MicrosoftはBing ChatとBing Chat Enterpriseをすべて「Copilot」に改名すると発表した。

ブランド変更の動きは、Copilotが、ユーザーが最初にBingに移動しなくてもアクセスできる、より自己完結型のエクスペリエンスになりつつあることを意味します。 Copilotの無料版は引き続きBingとWindowsでアクセスできますが、「copilot.microsoft.com」と呼ばれる専用ドメイン名も設定されます。

このCopilotマトリクスにさらに2つのメンバーが追加された理由について、Microsoftは、コンシューマーとエンタープライズの両方の顧客向けに統一されたCopilotエクスペリエンスを作成したかったと説明しました。

そのため、Bing ChatはMicrosoftの6番目の「Copilot」になりましたが、最も用途の広いCopilotとしても理解できます。

今後、Bingはそのサポートの一部になります。 さらに、CopilotはGPT-4やDALL・E3などの最新のOpenAIモデルに基づいており、統一されたエクスペリエンスでテキストと画像の生成機能を提供します。

Microsoftは自社の検索エンジンでAI製品を立ち上げることに多大な努力を払っており、Googleから市場シェアを奪う方法と見なしているため、現時点では売却は興味深いものです。 例えば、今年初め、MicrosoftのCEOであるNadellaは「Googleを検索における800ポンドのゴリラ」と呼んだが、Microsoftはそれを「ダンス」にするだろう。

しかしその後、GoogleはMicrosoftのように生成AI製品を検索結果に統合することを急いでいませんでした。 これまでのところ、この「変更なし」は悪い影響はありません:StatCounterによると、Bingチャットの発売からほぼ10か月後、Googleの検索エンジンは依然として91%以上の市場シェアを持っています。

マイクロソフトは、12月1日から、Bing、Edge、およびWindowsでCopilotを使用しているお客様は、Microsoft Entra IDでサインインするときに商用データ保護機能を利用できるようになると具体的に述べています。 Copilot はユーザーの応答を保存せず、Microsoft が直接アクセスすることも、基になるモデルのトレーニングにも使用されません。

此外,微软还推出了另外一些「Copilot」:Microsoft Copilot Studio、Copilot for Azure、Copilot for Service 和 Copilot in Dynamics 365 Guides。

その中で、MicrosoftのCopilot Studio製品は、MicrosoftがリリースしたAIアプリケーションをサードパーティのデータに接続するためのツールを提供し、企業がカスタムCopilotを作成したり、カスタムChatGPT AIチャットボットを統合したりできる新しいプラットフォームであるOpenAIのGPTに対してベンチマークされています。 この製品は、既存の Copilot for Microsoft 365 サブスクライバー向けのベータ版です。

Web ベースの Copilot Studio を使用すると、企業は、事前構築済みのコネクタまたはデータ ストレージ用の独自の構築済みコネクタを使用して、Copilot for Microsoft 365 と Copilot for Service に CRM、エンタープライズ リソース管理システム、およびその他のデータベース内のデータへのアクセスを提供できます。

LLMトレーニングと推論のための最初の5nm AIチップ

Bing Chatの名前をCopilotに変更することに加えて、視聴者によって広く開発されてきたMicrosoftの自社開発チップは、ついにその本当の色を明らかにしました。

Microsoftは、クラウドインフラストラクチャ用に設計された2つのハイエンドカスタムチップ、Azure Maia 100 AIチップとCobalt 100 CPUをリリースしました。 どちらのチップもMicrosoftによって社内で構築され、パフォーマンス、電力、コストを最適化するためにクラウドサーバースタック全体が大幅に刷新されており、2024年に利用可能になる予定です。

Maia 100 は、OpenAI のすべてのワークロードを強化する部分を含む、Microsoft Azure 上の最大の AI ワークロードを強化します。 Microsoftは、Maiaの設計およびテスト段階でOpenAIと協力してきたと述べています。

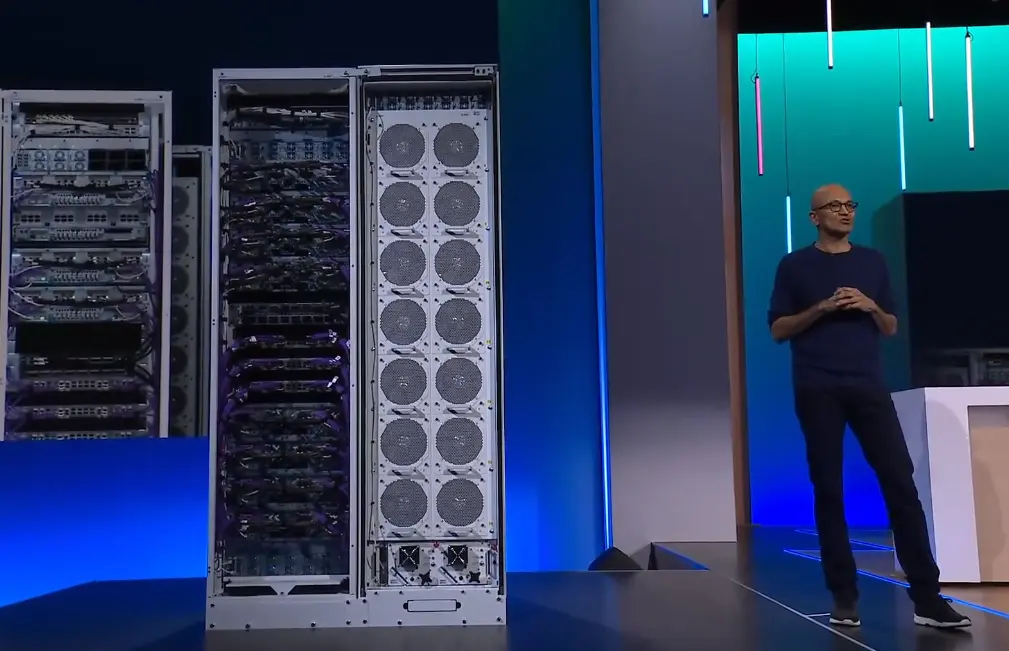

* *NadellaはMaia 100のサーバーラックと冷却システムを示しています

*NadellaはMaia 100のサーバーラックと冷却システムを示しています

青色の顔料にちなんで名付けられたCobalt 100は、Arm Neoverse CSS設計に基づいて構築された128コアチップで、Microsoft向けにカスタムビルドされています。 Cobalt 100は、Microsoft Azure上の汎用クラウドサービスを強化するように設計されています。 このチップに関して、Microsoftは高性能を保証するだけでなく、電源管理にも特別な注意を払っています。 同時に、このチップは、各コアと各仮想マシンのパフォーマンスと消費電力を意図的に制御するように設計されています。

Microsoftは現在、Microsoft TeamsやSQL ServerなどのワークロードでCobalt 100をテストしており、来年にはさまざまなワークロードを処理するための仮想マシンを顧客に提供する予定です。 Microsoft Azureで現在使用されているArmサーバーと比較すると、Cobalt 100はパフォーマンスが大幅に向上しています。

Microsoftの初期テストでは、Cobalt 100は、コモディティArmサーバーを使用している現在のデータセンターよりも40%のパフォーマンス向上を実現することが示されています。 ただし、Microsoftは完全なシステム仕様やベンチマークを開示していません。

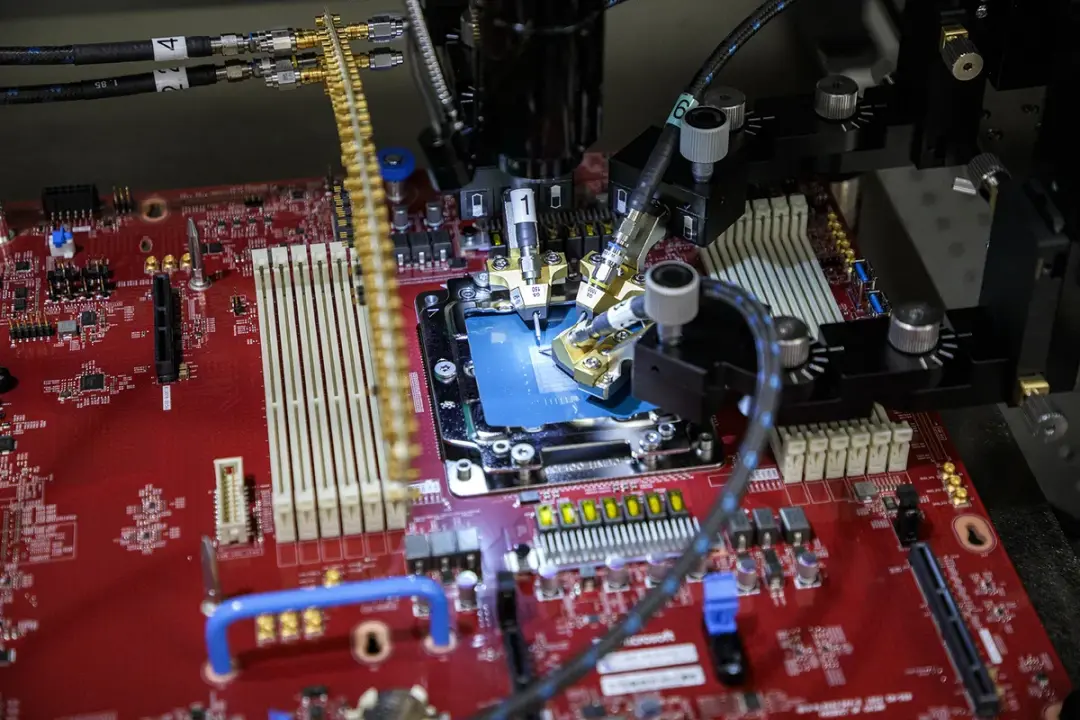

* *Microsoft Azure Cobalt システムオンチップをテストするためのプローブステーション

*Microsoft Azure Cobalt システムオンチップをテストするためのプローブステーション

ただし、Microsoftは、Maia 100とCobalt 100の両方が自己消費を優先し、独自のAzureクラウドサービスをサポートするとも述べています。

Phi-2 モデルの発行 (Azure AI Service で利用可能)

Microsoftは、27億個のパラメータを持つ新しいPhi-2モデルは、Phi-1-5と比較して推論力とセキュリティ対策が大幅に向上したと発表しましたが、それでも業界の他のTransformerと比較すると比較的小さいです。

そして、今年9月には、高品質な「スモールデータ」の可能性をさらに検証した論文「Textbooks Are All You Need II: phi-1.5 technical report」が発表されました。 この論文では、QA Q&A やコードなどのシナリオに適した 13 億個のパラメーターを持つ Phi-1.5 を提案します。

今日まで、Phi-2は正式にリリースされており、Microsoftのモデルの更新と反復は依然として非常に高速であることがわかります。

Phi-2 が Azure AI Services で利用できることは既に説明しました。 それだけでなく、OpenAIの音声認識モデルWhisper-Large-V3。 さまざまなマルチモーダルタスクを実行できるSalesforceのBLIPシリーズ、OpenAIのCLIPシリーズモデル、MetaのCode LlamaとSAM、Abu Dhabi Institute of Technology Innovation(TII)が開発した大規模なオープンソース言語モデルであるFalcon、Stability AIのStable Diffusionなどの新しいモデルがすべて含まれています。

参考リンク: